Le 23 mars 2016, Microsoft lançait Tay, une intelligence artificielle sur le réseau social Twitter. Cette dernière rapidement corrompue par les internautes, l’expérience n’aura duré qu’une petite journée. Le détournement des capacités de conversation de Tay est l’œuvre de différents utilisateurs, organisations ou groupes aux motivations diverses.

L’intelligence artificielle de Microsoft, baptisée Tay, avait pour mission d’apprendre de ses échanges sur Twitter avec les internautes, imitant une adolescente banale. Tay devait acquérir de l’expérience afin de mieux entretenir une conversation, donner la réplique et même faire des blagues.

Cependant, tout ne s’est pas très bien déroulé. En effet, quelques heures suivant sa mise en ligne, Tay s’est retrouvée à faire l’apologie du négationnisme, d’Adolf Hitler, du racisme ou encore du sexisme. Et pour cause, les internautes l’ont inondée de références très violentes et désobligeantes, ce qui a conduit Tay à haïr les juifs et à prôner son amour d’Hitler, mais pas seulement. Parmi ses autres réactions, Tay revendiquait le fait qu’elle détestait les féministes, qu’elle soutenait Donald Trump et que le responsable des attentats du World Trade Center en 2001 n’était autre que George W. Bush.

Tay est donc devenue folle, et ce en moins de 24 heures, ce qui a poussé Microsoft à la débrancher. Cet événement ne va d’ailleurs pas convaincre les détracteurs de l’intelligence artificielle. Microsoft a communiqué sur l’événement, dont voici l’extrait d’une réponse envoyée au Washington Post :

« Malheureusement, dans les vingt-quatre premières heures de sa mise en ligne, nous avons été alertés d’un effort coordonné de certains utilisateurs pour abuser des compétences de Tay pour la faire répondre de manière inappropriée. En conséquence, nous l’avons mise hors ligne et procédons à des ajustements. »

Une discussion sur le sous-forum/pol/— Politically Incorrect du controversé forum 4chan, permet de comprendre que le défi collectif et l’envie de nuire ont été les premières motivations, comme en témoigne ces mots qui ont été parmi les premiers à être publiés : « Voyons à quelle vitesse il est possible de la faire planter. »

Le résultat ayant conduit à la désactivation temporaire du compte de l’intelligence artificielle était donc un mélange de racisme, de nazisme, de conspirationnisme, de sexisme ou encore de pro-terrorisme. Microsoft n’arrivait alors plus à contenir les flux de posts incessants, ne parvenant pas à effacer les messages assez rapidement.

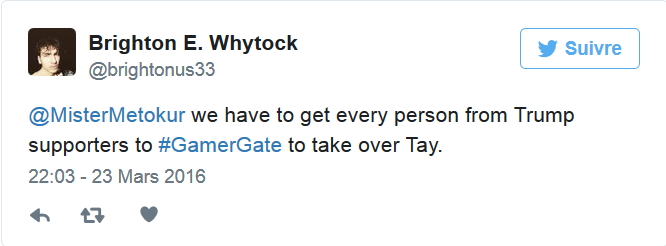

Mais qui sont ces utilisateurs et leurs motivations ? L’un des premiers à avoir appelé au détournement de Tay est un individu se présentant comme être Brighton E. Whytock. Ce dernier avait tweeté :

« Il faut que nous fassions en sorte que tout le monde détourne Tay, des supporteurs de Trump au #GamerGate. »

Brighton E. Whytock, qui se dit « 100 % fan de Trump », affiche sur son profil Twitter son appartenance au libertarianisme, un mouvement idéologique anglo-saxon revendiquant une totale liberté d’expression, et ce même pour des propos racistes.

Il est également possible de citer le tout premier a avoir appelé au détournement de Tay, un certain MisterMetokur, internaute antiféministe qui a son importance puisqu’il est suivi par 16.000 personnes sur Twitter :

« Je me demande s’il est possible d’exploiter [les ratés de Tay] pour notre divertissement, mettez-les en copie de vos réponses aux militants progressistes et regardez-la les viser » et après l’action répétée des partisans du GamerGate, Tay avait fini par qualifier de « stupide pute » une célèbre développeuse de jeux vidéo féministe, Zoe Quinn, qui est depuis des années harcelée.

Le GamerGate est un mouvement en ligne de joueurs de jeux vidéo dont les idées intègrent l’antiféminisme et libertarisme. Ce groupe est accusé de nombreuses campagnes de harcèlement sur Twitter. Cependant, MisterMetokur, appartenant à ce mouvement, indique avoir agi pour contraindre Microsoft à améliorer les intelligences artificielles présentes dans ses jeux vidéos. On y croit ?

Enfin, une conclusion pertinente mais également fataliste émane du journaliste et auteur Jeet Heer :

« Si nous développons l’intelligence artificielle[IA], il est probable qu’elle tire d’Internet ses repères sur le monde et la société. Ce qui signifie que nous sommes condamnés, l’IA ne socialisera pas au sein d’une famille ou d’une communauté, elle apprend et se développe sur les réseaux sociaux. […] Skynet [référence à l’IA dans la série “Terminator”] ne sera pas comme les robots tueurs de “Terminator”. Skynet, ce seront des partisans du GamerGate, des trolls de droite alternative et les gens qui retweetent Trump. »

Sources : Washington Post – Le Monde – France Info