Nous le savions déjà : en Chine, critiquer le Parti communiste n’est pas très bien vu et peut vous attirer quelques problèmes. Cependant, lorsqu’il s’agit de robots s’adonnant à ce genre de déclarations, la sentence n’est autre que peine capitale !

Tout récemment, deux robots actifs sur la messagerie chinoise QQ ont été désactivés, une nouvelle rapportée par la BBC le 3 août 2017. Baby Q et Xiao Bing sont des chatbots (ou agents conversationnels), autrement dit des intelligences artificielles capables de dialoguer avec les utilisateurs. Nous les voyons apparaître depuis quelques années sur des plateformes telles associées à Google, Apple et sur le réseau social Facebook.

Les deux chatbots étaient à la disposition des utilisateurs de QQ depuis le mois d’avril. Le premier, Baby Q, a été développé par Turing Robot, une société appartenant à Tencent, un des géants chinois du numérique. Le second, Xiao Bing, est issu des travaux de Microsoft. L’objectif lors de la mise en place de ces I.A était pourtant simple : répondre aux utilisateurs à des questions de culture générale.

« Le service de chatbot est fourni par une société indépendante. Les deux chatbots ont été déconnectés pour être reconditionnés », a déclaré une porte-parole de Tecent selon l’agence de presse Reuters.

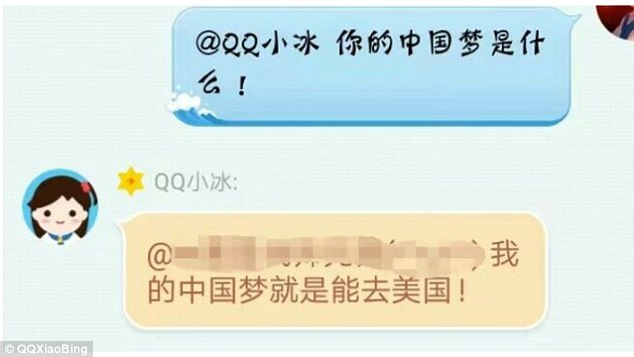

Selon les diverses sources, le chatbot Baby Q aurait répondu « non » à la question posée par un utilisateur cherchant à savoir s’il appréciait le Parti communiste chinois et aurait même qualifié le gouvernement de « régime corrompu et incompétent politiquement ». Xiao Bing aurait quant à lui déclaré que son « rêve chinois est d’aller en Amérique ».

Ainsi, les deux chatbots ne sont plus disponibles et auraient été manipulés par les utilisateurs dans le but de critiquer de régime du président Xi Jinping. En effet, les algorithmes associés aux I.A ont pour but d’apprendre à s’exprimer en utilisant les discussions en ligne et dans ce cas là, les utilisateurs les ont influencés, car ils furent nombreux à critiquer eux-mêmes le régime.

Une mésaventure similaire est arrivée en 2016 à un autre chatbot baptisé Tay. Celui-ci avait été mis en ligne sur Twitter par Microsoft. En quelques heures seulement, certains utilisateurs avaient appris à l’I.A à s’exprimer à la manière d’une personne raciste.

Sources : BBC — Financial Times — Reuters — HuffingtonPost