Un communiqué récent présente une avancée majeure dans le monde de la technologie et de l’intelligence artificielle (IA) : la création de la plus grande puce informatique jamais conçue, la Wafer Scale Engine 3 (WSE-3), par la société Cerebras. Cette puce est destinée à révolutionner la capacité de calcul nécessaire pour entraîner des systèmes d’IA de nouvelle génération.

Une puce qui allie taille et puissance

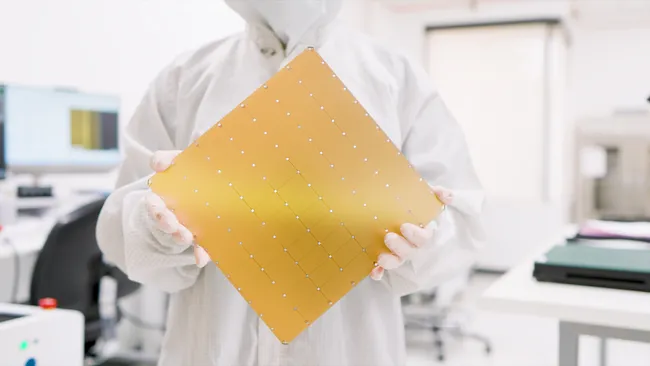

La WSE-3 est un colosse parmi les puces informatiques. Elle intègre en effet 4 000 milliards de transistors et 900 000 cœurs d’IA sur une surface de 21,5 cm par 21,5 cm. Cette troisième génération de puce de Cerebras succède ainsi à la WSE-2 de 2021 qui comptait 2 600 milliards de transistors et 850 000 cœurs d’IA.

Malgré sa taille impressionnante, la WSE-3 consomme toutefois la même quantité d’énergie que son prédécesseur, tout en offrant le double de puissance. Cela signifie que Cerebras a réussi à suivre la loi de Moore qui prévoit le doublement du nombre de transistors sur une puce environ tous les deux ans.

Pour mettre en perspective la puissance de la WSE-3, considérons le GPU Nvidia H200, l’une des unités de traitement graphique les plus avancées pour l’entraînement des IA, qui contient 80 milliards de transistors. La puce de Cerebras dépasse cela de 57 fois, mettant en évidence l’écart monumental en termes de capacité de calcul.

Une application future : le supercalculateur Condor Galaxy 3

La WSE-3 est conçue pour être le cœur du supercalculateur Condor Galaxy 3, actuellement en construction à Dallas, au Texas. Une fois terminé, ce supercalculateur consistera en 64 « blocs de construction » du système d’IA Cerebras CS-3, tous alimentés par la puce WSE-3. Il aura une capacité de 8 exaFLOP ou 8 quintillions d’opérations à virgule flottante par seconde, ce qui est environ huit fois la puissance du supercalculateur le plus puissant actuellement en service, le Frontier, qui atteint 1 exaFLOP.

Lorsqu’il sera combiné avec les systèmes Condor Galaxy 1 et 2, le réseau entier affichera alors une capacité de 16 exaFLOP. Cette puissance de calcul extraordinaire permettra ainsi de former des systèmes d’IA jusqu’à dix fois plus grands que des modèles actuels tels que GPT-4 ou Gemini de Google. Pour illustrer, GPT-4 utilise environ 1,76 billion de paramètres. En théorie, le Condor Galaxy 3 pourrait quant à lui gérer des IA avec jusqu’à 24 000 milliards de paramètres.

Quelles implications ?

Ce développement représente un bond en avant significatif dans la capacité des machines à apprendre et à exécuter des tâches de manière plus efficace et sophistiquée. La possibilité de former des IA avec une complexité et une taille sans précédent ouvre ainsi de nouvelles avenues dans la recherche, le développement de produits, la médecine personnalisée, la modélisation climatique, et bien plus encore.

En outre, cela pose des questions sur la gestion de la consommation d’énergie, l’éthique de l’IA et la sécurité des données qui devront être abordées à mesure que ces technologies évoluent.